Op dinsdag 3 maart werd een talrijk publiek met koffie, thee en boterkoeken onthaald in Liberas voor een studiedag over website-archivering. Deze studiedag vormt het sluitstuk van het project Catching the Digital Heritage, een samenwerking tussen Liberas en Amsab-ISG.

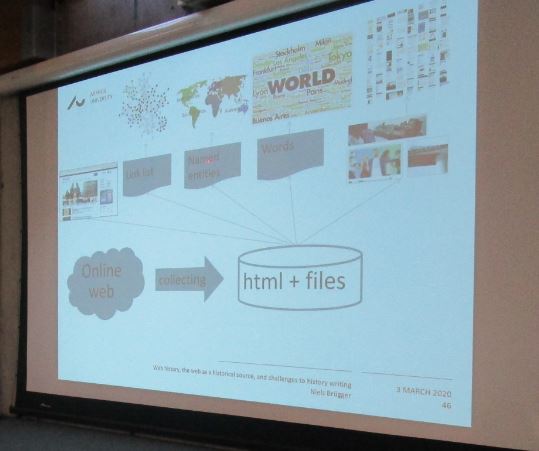

Na een inleiding door Peter Laroy (Liberas) over de opzet en uitwerking van het project, werd de toon meteen gezet door de keynote-lezing van prof. dr. Niels Brügger (Aarhus University, Denemarken). Het online web is een volatiele omgeving die continu aan verandering onderhevig is. Websites verschijnen, veranderen en verdwijnen voortdurend. Een voorbeeld van deze kwetsbaarheid is de website van het Witte Huis in de Verenigde Staten, die een opgemerkte wijziging doormaakte na de verkiezing van Trump als president. De pagina rond klimaatverandering werd immers snel na zijn aanstelling offline gehaald. Omdat born digital bronnen gestadig groeien, het web inherent deel uitmaakt van onze samenleving en dit web geen archief is maar snel verandert, is er nood om het online web te archiveren. Een dergelijk webarchief is een bron voor een brede waaier aan onderzoek, over zowat elk aspect van de samenleving. Door haar eigenheid stelt het web de archivaris en de onderzoeker echter voor een aantal uitdagingen. In tegenstelling tot gedigitaliseerde bronnen is het online web digital born, waardoor het meteen een aantal specifieke karakteristieken heeft. Zo bestaat het uit onmiddellijk uit minimaal twee lagen (zichtbare tekst en de HTML-code), is het fragmentair en zijn er steeds hyperlinks. Bij het archiveren van het web kan gebruik gemaakt worden van enkele methodes, waaronder web crawling, screen shots, screen movies, verzamelen via API of oude off/online content rechtstreeks bij de eigenaar opvragen. Het archiveren zelf is een complex, niet transparant en niet-systematisch proces, met een temporele dimensie waardoor het als het ware het ‘archiveren van een bewegend doelwit’ wordt. Bijgevolg is er steeds een inherente onzekerheid over de relatie tussen wat gearchiveerd is en het eigenlijke web. Niels Brügger stelt zich daarom de vraag of het gearchiveerde web een betrouwbare historische bron is. Er moet alleszins rekening gehouden worden met de eigenheid van gearchiveerde online content.

Sally Chambers (Ghent Centre for Digital Humanities) gaf enkele voorbeelden van onderzoeksprojecten in België naar webarchivering, waaronder het PROMISE-project, BeSocial en WARCnet. Daarnaast wees ze op de meerwaarde van webarchivering door kleinere organisaties zoals Liberas en Amsab-ISG. Intussen is reeds meer dan vijfentwintig jaar geschiedenis verloren gegaan doordat heel wat online bronnen niet systematisch bewaard zijn. Kleinere organisaties hebben een hands-on mentaliteit om hier verandering in te brengen. Door zich op specifieke aspecten van de samenleving en het web te richten, kunnen ze diepgaander archiveren dan grote spelers zoals The Internet Archive. Bovendien kunnen ze inspelen op specifieke gebeurtenissen en de online evenementen daarrond capteren. Het belangrijkste is vooral dat de gearchiveerde websites e.d. in de collectie bewaard blijven, waar ze door hun inbedding in de ruimere collectie een bredere betekenis krijgen.

Om de voormiddagsessies af te sluiten, lichtte Tine Vekemans (projectmedewerker van Catching the Digital Heritage) een tipje van de sluier over het project. Ze ging in op de doelstellingen, de werkwijze en de eerste conclusies van het project. Catching the Digital Heritage werd opgezet om 1) orde te brengen in het reeds verzamelde materiaal, 2) de best werkbare strategie op maat van de instellingen te ontwikkelen, en 3) een bijdrage te leveren aan het bredere erfgoedveld via de CESTwiki. Een eerste belangrijke vaststelling van de projectmedewerkers was dat organisaties die aan webarchivering willen doen veel aandacht moeten hebben voor kwaliteitscontrole. Indien er onmiddellijk na het binnenhalen van een website een kwaliteitscontrole gebeurd, kan eventueel nog een andere versie van de desbetreffende website worden gearchiveerd.

De broodjeslunch bood de deelnemers de kans om met elkaar in gesprek te gaan over hun ervaringen met en ideeën over webarchivering. Perspectieven, best practices en toekomstvisies werden naar hartenlust uitgewisseld.

In de namiddag vergastte Jeroen Fernandez-Alonso (projectmedewerker Catching the Digital Heritage) het publiek op twee lezingen over de praktische aspecten aan het archiveren van websites. Crawlers archiveren websites door links te volgen. Maar er zijn verschillende mogelijke crawlers met elk eigen voor- en nadelen. Tijdens het project werden HTTrack, Wget en Heritrix onder de loep genomen. Aangezien HTTrack enkel in HTML bewaart en niet in het standaard WARC-formaat, bleek dit niet de beste keuze. Uiteindelijk werd voor Heritrix geopteerd omdat de kwaliteit van de gearchiveerde websites beter is, deze volgens de meest recente standaard bewaard worden en ze relatief gemakkelijk gevisualiseerd kunnen worden. Nochtans is het gebruik van Heritrix technisch moeilijker dan HTTrack en Wget, onder meer omdat de configuratie sterk aangepast dient te worden. Na het bewaren van de websites dienen deze van metadata voorzien te worden. Hierbij is de vraag op welk niveau websites beschreven moeten worden. Er is een richtlijn voor de beschrijving van websites, maar er is geen uitgewerkte standaard beschikbaar. Uiteindelijk werd om pragmatische redenen gekozen om de beschrijvingen volgens ISAD(G) te doen. Hierbij werd één website als een deelarchief beschouwd, met de URL’s als een reeks en de snapshots als bestanddeel.

Na deze eerder technische uiteenzettingen ging Sophie Vandepontseele (KBR) dieper in op de juridische aspecten rond webarchivering. Het juridische kader rond de bescherming van persoonsgegevens en auteursrecht bieden heel wat uitdagingen aan instellingen die online content willen archiveren. Binnen de strikte interpretatie geldt immers de verplichting om aan alle rechthebbenden expliciet toestemming te vragen. Dit is bijna onmogelijk door de schier eindeloze hoeveelheid te archiveren websites, de moeilijkheid om de rechthebbenden te identificeren en de specifieke karakteristieken van websites (waaronder de gefragmenteerdheid en de vele links). De spreekster stelde dan ook dat er nood is aan een aanpassing van de wetgeving.

Vervolgens gaf Maarten Savels (Amsab-ISG) een helder inzicht in de moeilijkheden en mogelijkheden voor de opslag en ontsluiting van gearchiveerde websites. Na het binnenhalen van websites dienen deze eerst gecontroleerd te worden op hun kwaliteit. In principe zou ook schonen zinvol zijn, ware het niet dat dit technische moeilijkheden oplevert. Ook een analyse van alle gearchiveerde bestandsformaten is niet gemakkelijk. Bij de opslag van gearchiveerde online content komen heel wat veiligheidseisen kijken. Amsab-ISG bewaart de door haar gearchiveerde websites op NAS (RAID6) waarop de inhoud gespiegeld is en waarvan een back-up bestaat. Regelmatig moet het materiaal een kwaliteitscontrole ondergaan om na te gaan of een versie nog leesbaar is, onderhevig aan bit-rot enzovoort. De preservatie kan op dit moment enkel op bit level. Weliswaar zijn er al eerste aanzetten om dit op een hoger niveau toe te passen en te automatiseren, maar het is nog verder afwachten hoe dit verder zal ontwikkelen. Opmerkelijk is dat de websites, die voorheen online toegankelijk waren, na hun archivering enkel intra muros aangeboden kunnen worden aan onderzoekers. Dit omwille van de beperkende wetgeving inzake de bescherming van persoonsgegevens en auteursrecht.

De boeiende studiedag werd afgesloten door Kim Robensyn (Amsab-ISG). Zij stelde dat alle sprekers heel wat stof tot nadenken hadden geleverd en heel wat toekomstperspectieven hadden geleverd voor het webarchiveren in Vlaanderen. De bijeenkomst vormde een mooi sluitstuk van het project Catching the digital heritage, maar is zeker geen eindpunt. Liberas en Amsab-ISG gebruiken het project als opstap voor de verdere uitbouw van hun strategieën op vlak van webarchivering en zullen ook in de toekomst de online ontwikkelingen nauw op de voet volgen. Zo is er bijvoorbeeld nu al volop aandacht voor het archiveren van sociale media, al is de realisatie hiervan wellicht nog verre toekomstmuziek

Meer informatie over het project Catching the Digital Heritage en handleidingen om zelf websites te archiveren kunnen gevonden worden via de CESTwiki: https://www.projectcest.be/wiki/Publicatie:Project:_Catching_the_digital_heritage